Deep Residual Shrinkage Network (DRSN) je poboljšana varijanta Deep Residual Network (ResNet) arhitekture. U suštini, radi se o integraciji Deep Residual Network-a, mehanizama pažnje (attention mechanisms) i funkcija soft thresholdinga (soft thresholding functions).

U određenoj mjeri, princip rada Deep Residual Shrinkage Network-a se može razumjeti na sljedeći način: koristi mehanizme pažnje kako bi uočio nevažne značajke (features), a zatim koristi funkcije soft thresholdinga da ih postavi na nulu; ili drugim riječima, uočava važne značajke i zadržava ih. Ovaj proces pojačava sposobnost duboke neuronske mreže da izvuče korisne značajke iz signala koji sadrže šum.

1. Motivacija istraživanja

Prvo, prilikom klasifikacije uzoraka, prisustvo šuma – kao što su Gausov šum, ružičasti šum (pink noise) i Laplaceov šum – je neizbježno. U širem smislu, uzorci često sadrže informacije koje su nebitne za trenutni zadatak klasifikacije, što se također može tumačiti kao šum. Ovaj šum može negativno utjecati na performanse klasifikacije. (Soft thresholding je ključni korak u mnogim algoritmima za uklanjanje šuma, tj. signal denoising).

Na primjer, tokom razgovora pored ceste, zvuk govora može biti pomiješan sa zvukovima automobilskih truba i točkova. Kada se na ovim signalima vrši prepoznavanje govora (speech recognition), rezultati će neizbježno biti pod utjecajem tih pozadinskih zvukova. Iz perspektive dubokog učenja (Deep Learning), značajke koje odgovaraju trubama i točkovima trebale bi biti eliminisane unutar duboke neuronske mreže kako bi se spriječilo da utječu na rezultate prepoznavanja govora.

Drugo, čak i unutar istog skupa podataka, količina šuma često varira od uzorka do uzorka. (Ovo ima sličnosti sa mehanizmima pažnje; uzimajući skup slika kao primjer, lokacija ciljanog objekta može se razlikovati na različitim slikama, a mehanizam pažnje može fokusirati pažnju na specifičnu lokaciju ciljanog objekta na svakoj slici).

Na primjer, kada treniramo klasifikator za mačke i pse, uzmimo pet slika označenih kao “pas”. Prva slika može sadržavati psa i miša, druga psa i gusku, treća psa i kokoš, četvrta psa i magarca, a peta psa i patku. Tokom treniranja, klasifikator će neizbježno biti pod utjecajem nebitnih objekata kao što su miševi, guske, kokoši, magarci i patke, što rezultira padom tačnosti klasifikacije. Ako bismo mogli uočiti ove nebitne objekte – miševe, guske, kokoši, magarce i patke – i eliminisati značajke koje im odgovaraju, moguće je povećati tačnost klasifikatora za mačke i pse.

2. Soft Thresholding

Soft thresholding je ključni korak u mnogim algoritmima za uklanjanje šuma. On eliminiše značajke čija je apsolutna vrijednost manja od određenog praga (threshold), a značajke čija je apsolutna vrijednost veća od tog praga “skuplja” (shrinks) prema nuli. Može se implementirati koristeći sljedeću formulu:

\[y = \begin{cases} x - \tau & x > \tau \\ 0 & -\tau \le x \le \tau \\ x + \tau & x < -\tau \end{cases}\]Izvod izlaza soft thresholdinga u odnosu na ulaz je:

\[\frac{\partial y}{\partial x} = \begin{cases} 1 & x > \tau \\ 0 & -\tau \le x \le \tau \\ 1 & x < -\tau \end{cases}\]Kao što je prikazano iznad, izvod soft thresholdinga je ili 1 ili 0. Ovo svojstvo je identično kao kod ReLU aktivacijske funkcije. Stoga, soft thresholding također može smanjiti rizik da algoritmi dubokog učenja naiđu na probleme nestajanja gradijenta (gradient vanishing) i eksplodiranja gradijenta (gradient exploding).

U funkciji soft thresholdinga, postavljanje praga mora zadovoljiti dva uslova: prvo, prag mora biti pozitivan broj; drugo, prag ne smije biti veći od maksimalne vrijednosti ulaznog signala, inače će izlaz biti u potpunosti nula.

Osim toga, poželjno je da prag zadovoljava i treći uslov: svaki uzorak treba imati svoj nezavisni prag zasnovan na vlastitoj količini šuma.

To je zato što količina šuma često varira među uzorcima. Na primjer, uobičajeno je da unutar istog skupa podataka Uzorak A sadrži manje šuma, dok Uzorak B sadrži više šuma. U tom slučaju, prilikom primjene soft thresholdinga u algoritmu za uklanjanje šuma, Uzorak A bi trebao koristiti manji prag, dok bi Uzorak B trebao koristiti veći prag. Iako ove značajke i pragovi gube svoje eksplicitne fizikalne definicije u dubokim neuronskim mrežama, osnovna logika ostaje ista. Drugim riječima, svaki uzorak bi trebao imati svoj nezavisni prag određen njegovim specifičnim sadržajem šuma.

3. Mehanizam pažnje (Attention Mechanism)

Mehanizme pažnje je relativno lako razumjeti u oblasti računarskog vida (Computer Vision). Vizualni sistemi životinja mogu razlikovati ciljeve brzim skeniranjem čitavog područja, a zatim fokusiranjem pažnje na ciljani objekt kako bi izvukli više detalja, istovremeno potiskujući nebitne informacije. Za detalje, molimo pogledajte literaturu o mehanizmima pažnje.

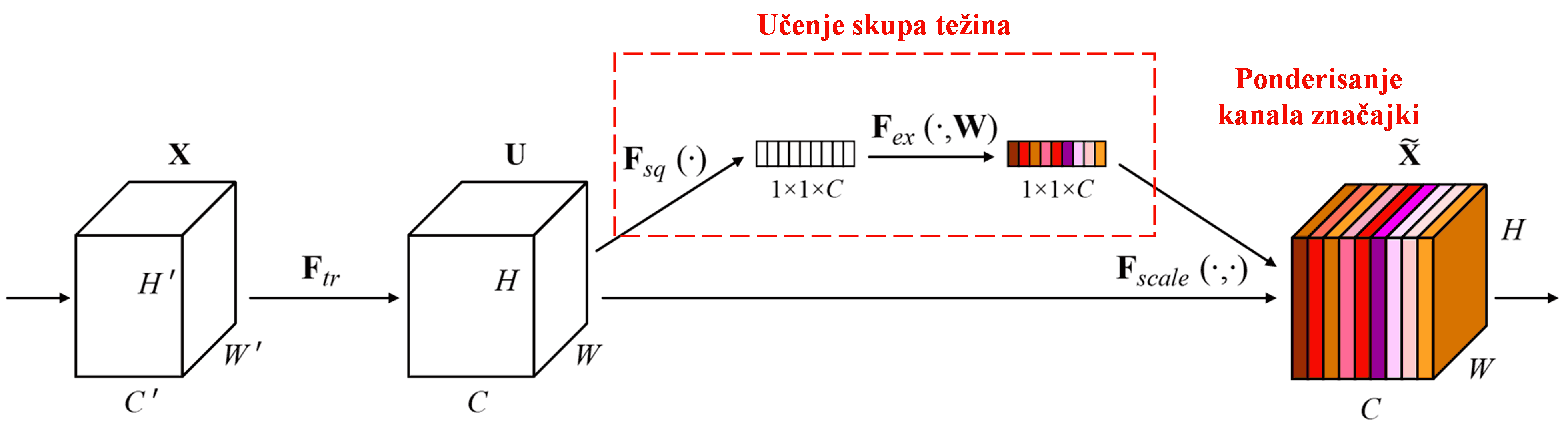

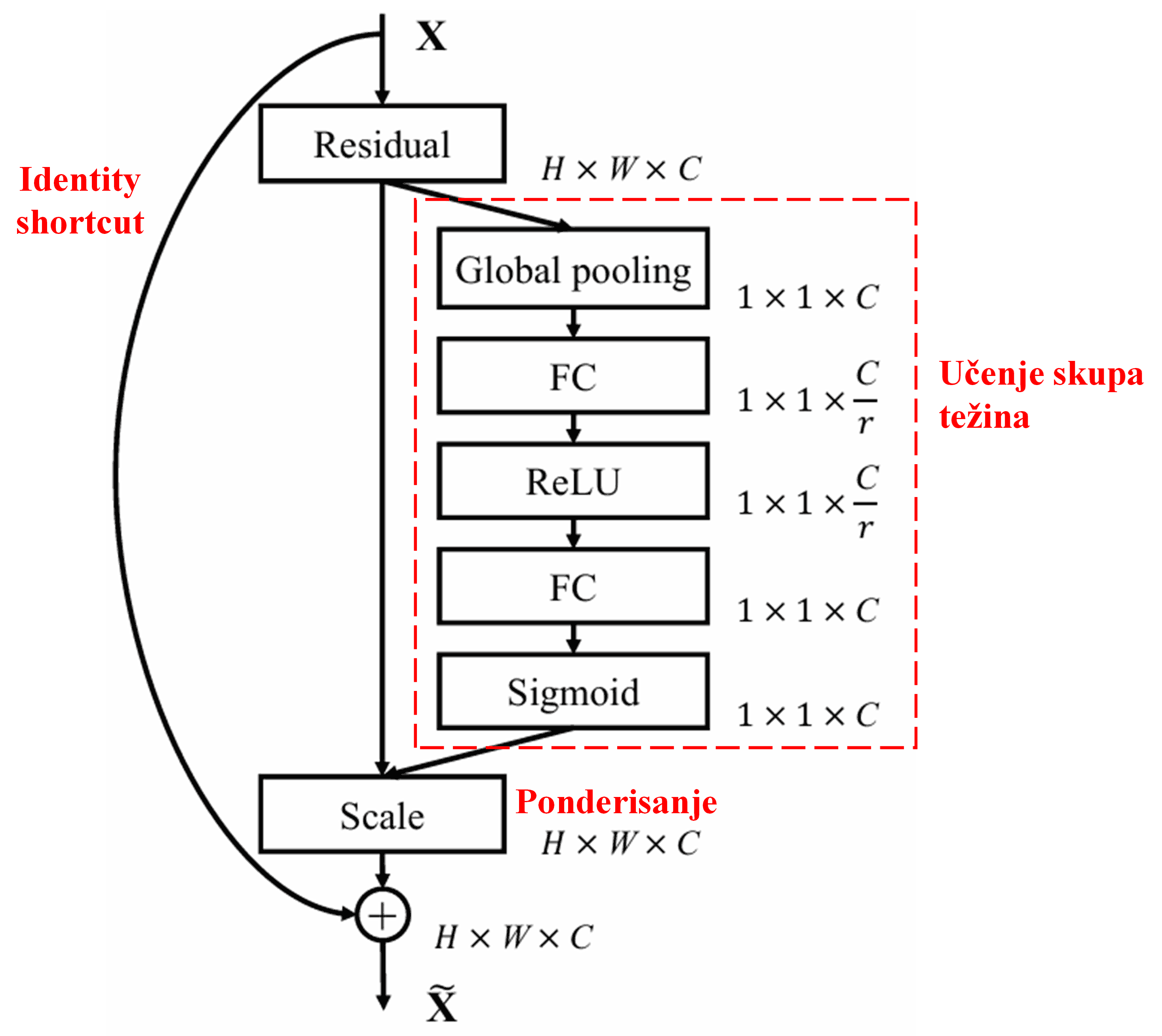

Squeeze-and-Excitation Network (SENet) predstavlja relativno novu metodu dubokog učenja koja koristi mehanizme pažnje. Kroz različite uzorke, doprinos različitih kanala značajki (feature channels) zadatku klasifikacije često varira. SENet koristi malu pod-mrežu kako bi dobio skup težina (weights), a zatim množi te težine sa značajkama odgovarajućih kanala kako bi prilagodio veličinu značajki u svakom kanalu. Ovaj proces se može posmatrati kao primjena različitih nivoa pažnje na različite kanale značajki.

U ovom pristupu, svaki uzorak posjeduje svoj nezavisni skup težina. Drugim riječima, težine za bilo koja dva proizvoljna uzorka su različite. U SENet-u, specifična putanja za dobivanje težina je “Global Pooling → Potpuno povezani sloj (Fully Connected Layer) → ReLU funkcija → Potpuno povezani sloj → Sigmoid funkcija”.

4. Soft Thresholding pod dubokim mehanizmom pažnje

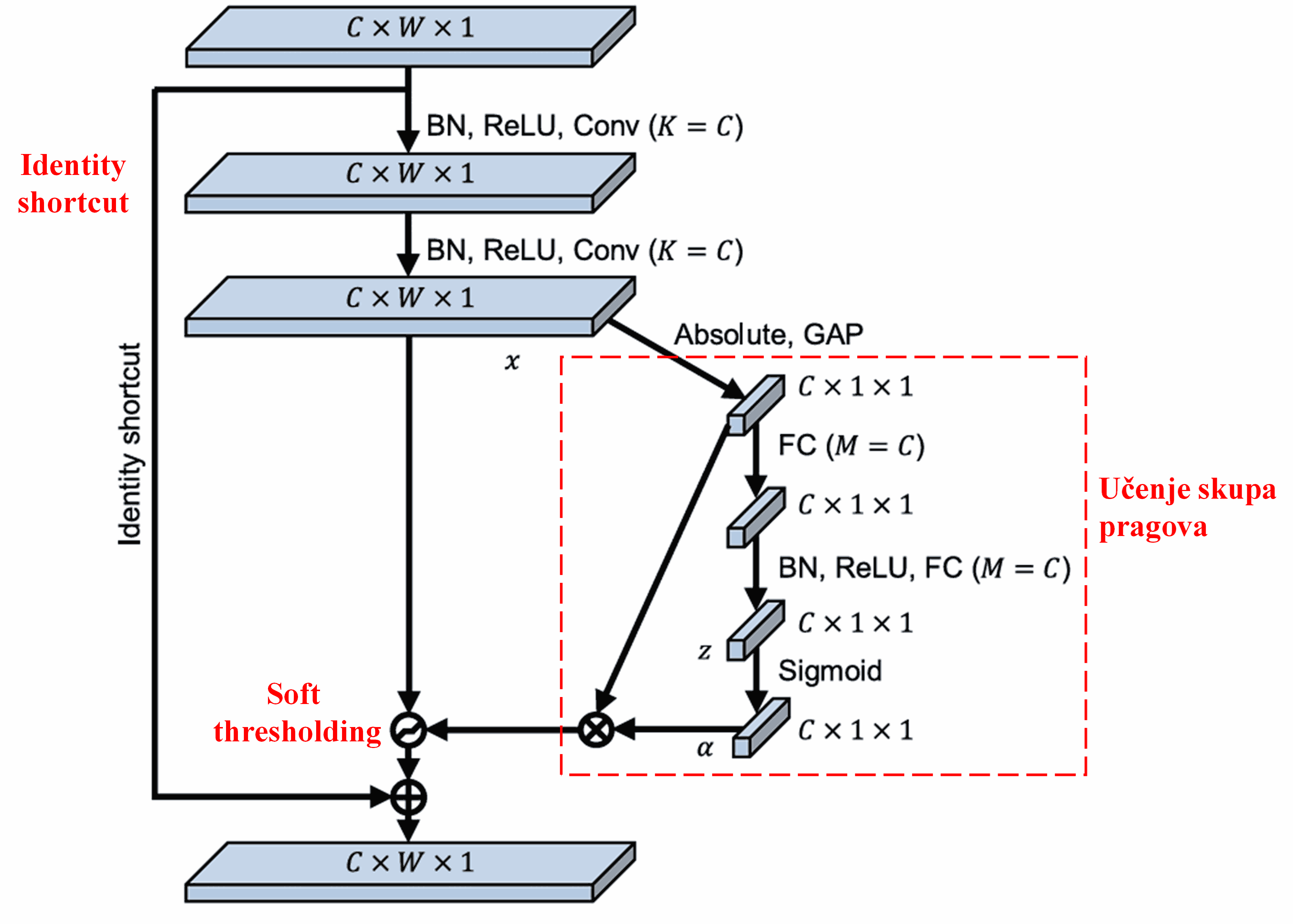

Deep Residual Shrinkage Network crpi inspiraciju iz gore spomenute strukture SENet pod-mreže kako bi implementirao soft thresholding unutar dubokog mehanizma pažnje. Kroz pod-mrežu (označenu crvenim okvirom na dijagramima), može se naučiti skup pragova kako bi se primijenio soft thresholding na svaki kanal značajki.

U ovoj pod-mreži, prvo se izračunavaju apsolutne vrijednosti svih značajki u ulaznoj mapi značajki (feature map). Zatim se, kroz globalno usrednjavanje (Global Average Pooling), dobija značajka označena kao A. U drugoj putanji, mapa značajki nakon globalnog usrednjavanja se unosi u malu potpuno povezanu mrežu. Ova mreža koristi Sigmoid funkciju kao svoj posljednji sloj kako bi normalizovala izlaz između 0 i 1, dajući koeficijent označen kao α. Konačni prag se može izraziti kao α × A. Dakle, prag je proizvod broja između 0 i 1 i prosjeka apsolutnih vrijednosti mape značajki. Ova metoda osigurava da prag nije samo pozitivan, već i da nije pretjerano velik.

Štaviše, različiti uzorci rezultiraju različitim pragovima. Posljedično, u određenoj mjeri, ovo se može tumačiti kao specijalizirani mehanizam pažnje: primjećuje značajke koje su nebitne za trenutni zadatak, transformiše ih u vrijednosti bliske nuli putem dva konvolucijska sloja, i postavlja ih na nulu koristeći soft thresholding; ili alternativno, primjećuje značajke relevantne za trenutni zadatak, transformiše ih u vrijednosti daleko od nule putem dva konvolucijska sloja, i zadržava ih.

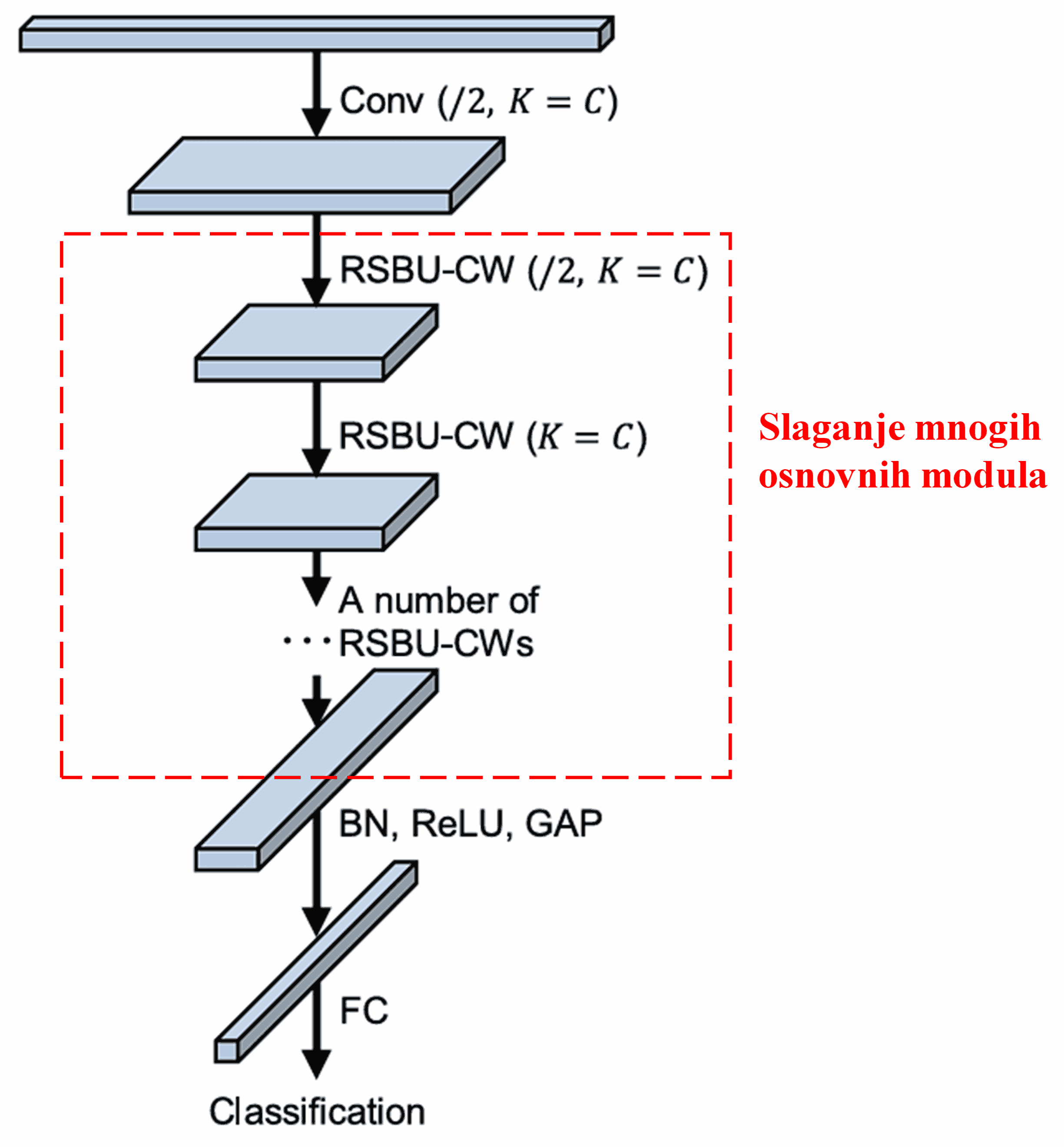

Konačno, slaganjem određenog broja osnovnih modula zajedno sa konvolucijskim slojevima, Batch Normalization slojevima, aktivacijskim funkcijama, Global Average Pooling slojevima i potpuno povezanim izlaznim slojevima, dobija se kompletna Deep Residual Shrinkage Network.

5. Sposobnost generalizacije

Deep Residual Shrinkage Network je, zapravo, univerzalna metoda za učenje značajki (feature learning). To je zato što, u mnogim zadacima učenja značajki, uzorci manje ili više sadrže određeni šum kao i nebitne informacije. Ovaj šum i nebitne informacije mogu utjecati na performanse učenja značajki. Na primjer:

U klasifikaciji slika, ako slika istovremeno sadrži mnogo drugih objekata, ti objekti se mogu shvatiti kao “šum”. Deep Residual Shrinkage Network može koristiti mehanizam pažnje da primijeti taj “šum”, a zatim upotrijebiti soft thresholding da postavi značajke koje odgovaraju tom “šumu” na nulu, čime se potencijalno povećava tačnost klasifikacije slika.

U prepoznavanju govora, posebno u relativno bučnim okruženjima kao što su razgovori pored ceste ili unutar tvorničke hale, Deep Residual Shrinkage Network može poboljšati tačnost prepoznavanja govora, ili barem ponuditi metodologiju sposobnu za poboljšanje tačnosti prepoznavanja govora.

Reference

Minghang Zhao, Shisheng Zhong, Xuyun Fu, Baoping Tang, Michael Pecht, Deep residual shrinkage networks for fault diagnosis, IEEE Transactions on Industrial Informatics, 2020, 16(7): 4681-4690.

https://ieeexplore.ieee.org/document/8850096

BibTeX

@article{Zhao2020,

author = {Minghang Zhao and Shisheng Zhong and Xuyun Fu and Baoping Tang and Michael Pecht},

title = {Deep Residual Shrinkage Networks for Fault Diagnosis},

journal = {IEEE Transactions on Industrial Informatics},

year = {2020},

volume = {16},

number = {7},

pages = {4681-4690},

doi = {10.1109/TII.2019.2943898}

}

Akademski utjecaj

Ovaj rad ima preko 1400 citata na Google Scholar-u.

Prema konzervativnim procjenama, Deep Residual Shrinkage Networks (DRSN) su korištene u više od 1000 publikacija. Ovi radovi su ili direktno primijenili ili poboljšali mrežu u širokom spektru oblasti, uključujući mašinstvo, elektroenergetiku, računarski vid, zdravstvo, obradu govora, analizu teksta, radar i daljinska istraživanja.